Az OSZK Digitális Bölcsészeti Központja (DBK) 2023-ban hetedik alkalommal tartotta meg az internetes tartalmak archiválásával foglalkozó éves rendezvényét, a „404 Not Found – Ki őrzi meg az internetet?” konferenciát és workshopot. A résztvevők száma megközelítette a kilencvenet, ebből több mint ötvenen online követték az eseményt, melynek középpontjában a nemzeti könyvtár webarchiválási tevékenységének megújítása, újfajta eszközök, technológiák és az új intézményi kapcsolatok bemutatása állt. A DBK ismertette a webarchívumhoz kapcsolódó legújabb tevékenységeket, a célzott adatmentést scrapingmódszerrel, a mesterséges intelligencia használatát és a szegedi egyetemi könyvtárral közösen épített Karikó-webarchívumot. A konferencia egyúttal záróeseménye volt a Luxembourgi Nemzeti Könyvtárral közösen elnyert nemzetközi pályázatnak. A luxemburgi kollégák két előadásban mutatták be tevékenységüket, valamint egy workshopot is tartottak a használt technológiákról.

A rendezvény hirdetménye itt olvasható, a plakátja pedig innen tölthető le.

Az előadások listája, kivonatai és prezentációi:

- Gerencsér Judit főigazgató-helyettes (OSZK): Köszöntő (videó: 51,6 MB)

- Ben Els (BNL): Curatorial Aspects of the Luxembourg Web Archive (prezentáció: 38,9 MB, videó: 479,4 MB) [A prezentáció helyes megjelenítéséhez szükséges betűtípus letöltése.]

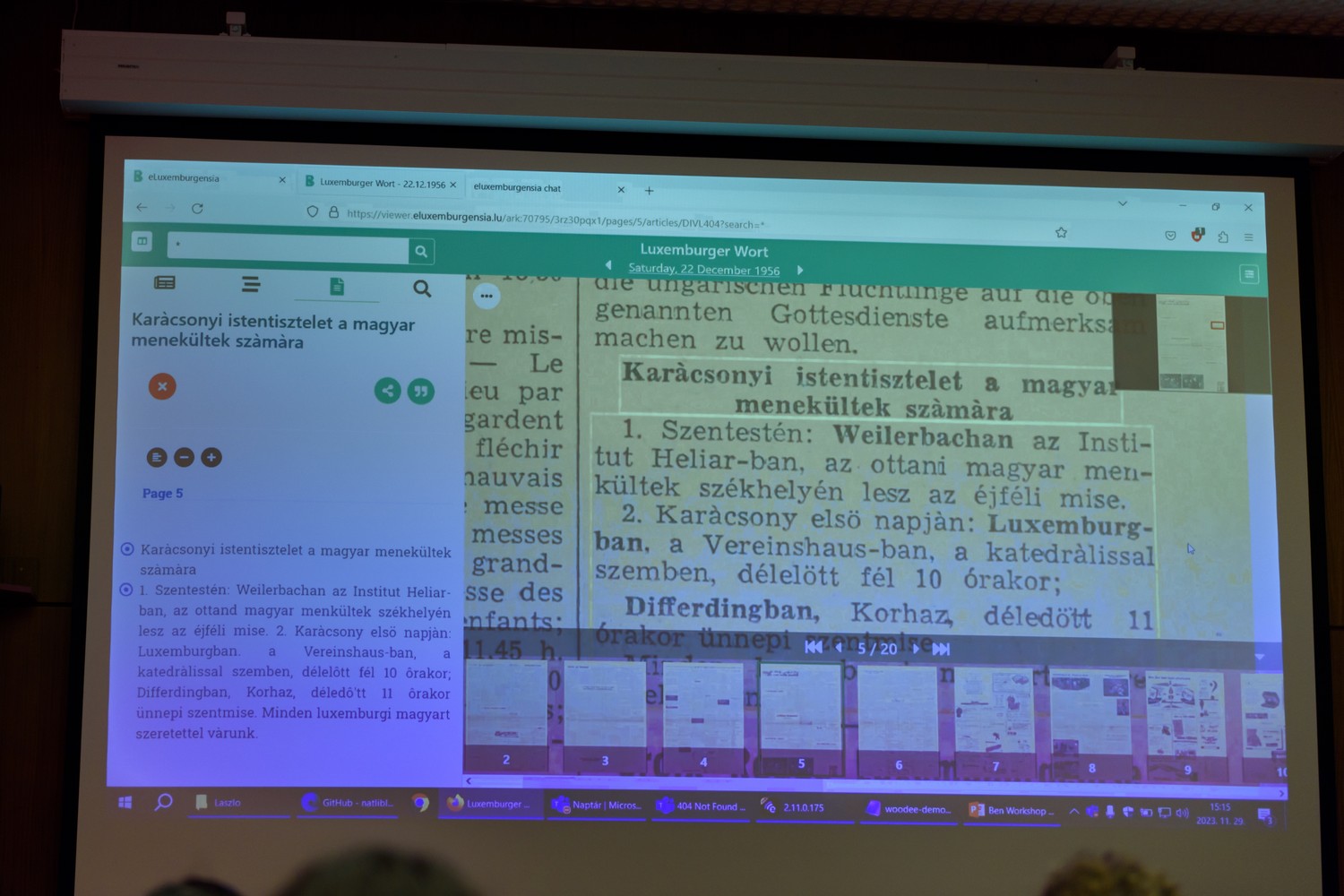

Since 2016, the National Library of Luxembourg preserves the Luxembourg web under national legal deposit. The Internet is changing at a rapid pace and there are a lot of obstacles in providing the best possible coverage for all websites in the Luxembourg web sphere. Archiving institutions have to balance between limited resources, in terms of budget, technical capacities and manpower, while also facing challenges in terms of tool development and accessibility for different user groups. This presentation will cover the operating modes and types of collections of the Luxembourg Web Archive, team setup and contracted services, our collection policy and plans for collaborative curation. We will have a look at the particularities of the Luxembourg legal deposit and its impact on the launch of a web archiving program at the National Library. We will cover different thematic and event collections and how they are presented on our information and participation platform webarchive.lu. Moreover, we will take a look at what examples of the Hungarian language, Hungarian websites and the Hungarian community in Luxembourg can be discovered in our current collections. We will dive into the different search options that help us to explore large web archive datasets.

- László Tóth (BNL): Technical Aspects of the Luxembourg Web Archive (prezentáció: 1,7 MB, videó: 314,7 MB)

In this presentation, we will detail the Luxembourg web archive from a technical viewpoint. We will discuss our harvesting methods (seasonal, thematic, and behind-the-paywall harvests), our technical infrastructure (servers, configurations) as well as various statistics of our web archives. In particular, we will present our in-house Browsertrix-based crawler, that allows us to perform cross-crawl deduplication, i.e., harvesting only the resources that were not already harvested during previous campaigns. Our method allows us to harvest an entire website domain in less than an hour and, in some cases, as little as 5 to 10 minutes. This will be followed by a short description of our current, as well as new, hardware. Indeed, the BnL has recently upgraded its web archiving hardware, including 4 high-performance servers with 96 cores and 768 GB RAM each. These machines will host our new indexing and playback solutions, comprising of a hybrid system including PyWb, OutbackCDX and a Solr cluster used by SolrWayback. Our indexers are set to work non-stop for about three weeks to index our entire web archive of 300 TB WARC files into Solr, thus enabling full-text search and other advanced features. Finally, we will briefly speak about the migration of our entire web archives into a new storage based on IBM S3 object storage solution, and the subsequent adaptation of existing software such as PyWb and SolrWayback to be able to efficiently load WARC data directly from S3 buckets.

- Drótos László (OSZK): Az OSZK webarchívumának megújítása (prezentáció: 4,7 MB, videó: 1929,7 MB)

Az OSZK webarchiválási tevékenysége 2017-ben indult, az azóta eltelt hat év tapasztalatai alapján megérett a helyzet az organikusan kialakult rendszer újragondolására. Az előadás a 2023. évi helyzetjelentés mellett bemutatja a webarchívum 2.0-s verziójának tervezetét, melynél a főbb szempontok a következők: a munkafolyamatok automatizálása, az archiválás minőségének javítása, a metaadatok egységes nyilvántartása, a gyűjtemény kutatásra és hosszú távú megőrzésre alkalmassá tétele.

- Kiss Márta Éva – Pálfy Anna (SZTE EK): Megvalósult álmok – Helyzetjelentés a szegedi Karikó-webarchiválásról (prezentáció: 3,5 MB, videó: 187,0 MB)

A tavalyi 404-konferencián dr. Kokas Károly A virtuális kiállítástól az archiválásig: Karikó Katalin nyomában című előadásában beszélt az SZTE Klebelsberg Könyvtár Karikó-gyűjteményéről és a tervezett webarchívum kialakításának főbb pontjairól. Azóta eltelt majd egy év, az együttműködés létrejött, és elindult az archiválási tevékenység is. Idei előadásunkban a virtuális kiállítás továbbfejlesztéséről, az eltelt évben végzett munkáról és a jövőbeli feladatokról hallanak majd. Szó lesz az új és lehetséges kihívásokról is, melyekkel találkozhatunk a frissen Nobel-díjat nyerő Karikó Katalin személyéhez kapcsolódó gyűjtemény továbbépítése során.

- Kalcsó Gyula (OSZK): A scrapingtechnológia használata és helye a webarchiválásban (prezentáció: 8,3 MB, videó: 221,1 MB)

Az OSZK webarchiválási tevékenysége elsősorban tömeges webaratást jelent a Heritrix szoftverrel, ezenkívül azonban kisebb mennyiségben, de minél jobb minőségre törekedve mentünk egyedi webhelyeket, webhelyrészeket vagy akár egyedi weboldalakat és egyéb fájlokat is. Ugyanakkor vannak olyan esetek, amikor nem lehet vagy nem szükséges az eredeti felületet archiválni és megjeleníteni, hanem elegendő csak a releváns tartalmat és bizonyos metaadatokat begyűjteni úgynevezett web scraping módszerrel. Ilyen feladat lehet például a webarchívum podcastállományának bővítése, cikkek begyűjtése szövegkorpuszok építéséhez vagy a DKA gyarapítása szabadon felhasználható digitális fotókkal. Az előadás az első ilyen nagyobb scrapingprojektünket mutatja be a kozterkep.hu példáján keresztül.

- Simon Eszter: A webaratásból származó szövegek automatikus feldolgozása (prezentáció: 0,7 MB, videó: 715,8 MB)

A webaratásból a sok egyéb formátum mellett nagy mennyiségű szöveges anyag is keletkezik. Ezen az anyagon a természetesnyelv-feldolgozás (natural language processing, NLP) eszközeit alkalmazva egy hatalmas méretű szövegkorpusz jön létre, amiből egyrészt sok hasznos és érdekes adatot lehet kinyerni, másrészt bemenete és segédeszköze lehet további nyelvfeldolgozó lépéseknek. Előadásomban a webaratásból származó szövegek feldolgozásának lépéseit mutatom be, valamint felvázolom azokat a jövőbeli fejlesztési irányokat, amelyeket tervezünk a webarchívumon csinálni. Utóbbiak közé tartozik az automatikus tárgyszavazás és topikmodellezés, valamint nagy nyelvi modellek (large language models, LLMs) tanítása is.

Délutáni workshop:

- László Tóth (BNL): Browsertrix Cloud (prezentáció: 2,2 MB, videó: 379,6 MB)

- Ben Els (BNL): From Luxemburgensia to Hungarica (prezentáció: 28,3 MB, videó: 1793,4 MB)

Using AI, we follow the traces of Hungarian culture through the BnL’s collections of digitised newspapers and web archives.

Fényképek a rendezvényről:

(A fotókat Visky Ákos László készítette.)